Les simulateurs informatiques d'Univers PROJET HORIZON - Partie 2

ARTICLE complet de 42 PAGES sur le MILLENIUM RUN ci-dessous en anglais :

http://www.mpa-garching.mpg.de/galform/mill^ page 3 in http://www.mpa-garching.mpg.de/galform/millennium/0504097.pdfennium/0504097.pdf

---------------------------------------------------------------------------

GADGET

From Wikipedia, the free encyclopedia

GADGET is a freely available code for cosmological N-body/SPH simulations written by Volker Springel at the Max Planck Institute for Astrophysics. This article describes version 2 of GADGET (known as GADGET-2).

[edit] Description

GADGET computes gravitational forces with a hierarchical tree algorithm (optionally in combination with a particle-mesh scheme for long-range gravitational forces) and represents fluids by means of smoothed particle hydrodynamics (SPH). The code can be used for studies of isolated systems, or for simulations that include the cosmological expansion of space, both with or without periodic boundary conditions. In all these types of simulations, GADGET follows the evolution of a self-gravitating collisionless N-body system, and allows gas dynamics to be optionally included. Both the force computation and the time stepping of GADGET are fully adaptive, with a dynamic range which is, in principle, unlimited.

GADGET can therefore be used to address a wide array of astrophysically interesting problems, ranging from colliding and merging galaxies, to the formation of large-scale structure in the universe. With the inclusion of additional physical processes such as radiative cooling and heating, GADGET can also be used to study the dynamics of the gaseous intergalactic medium, or to address star formation and its regulation by feedback processes.

[edit] History

The first public version (GADGET-1, released in March 2000), was created as part of Volker's PhD project under the supervision of Simon White. Later, the code was continuously improved during postdocs of Volker Springel at the Harvard-Smithsonian Center for Astrophysics and the Max Planck Institute, in collaboration with Simon White and Lars Hernquist.

The second public version (GADGET-2, released in May 2005), contains most of these improvements, except for the numerous physics modules developed for the code that go beyond gravity and ordinary gas-dynamics. The most important changes lie in a new time integration model, a new tree-code module, a new communication scheme for gravitational and SPH forces, a new domain decomposition strategy, a novel SPH formulation based on entropy as indepedent variable, and finally, in the addition of the TreePM functionality.

[edit] See also

À titre d’exemple, un documentaire récent de la BBC, Most of Our Universe is Missing, diffusé sur les ondes de Radio-Canada, expose ce houleux débat autour de la matière sombre, cette partie manquante de l’Univers qu’on tente d’incorporer dans le nouveau modèle standard cosmologique. Malgré de nombreuses lectures en astrophysique, dois-je avouer que cette émission a eu un effet choc. Je ne m’étais pas encore penché sur cet aspect de la recherche cosmologique, étant encore en train de digérer Le roman du Big Bang de Simon Singh et les complexes problèmes de géométrie non euclidienne reliés à la théorie des cordes dans l’Univers élégant de Brian Greene. Voilà bien la conséquence d’une recherche personnelle, quand on est chercheur sans papiers !

À titre d’exemple, un documentaire récent de la BBC, Most of Our Universe is Missing, diffusé sur les ondes de Radio-Canada, expose ce houleux débat autour de la matière sombre, cette partie manquante de l’Univers qu’on tente d’incorporer dans le nouveau modèle standard cosmologique. Malgré de nombreuses lectures en astrophysique, dois-je avouer que cette émission a eu un effet choc. Je ne m’étais pas encore penché sur cet aspect de la recherche cosmologique, étant encore en train de digérer Le roman du Big Bang de Simon Singh et les complexes problèmes de géométrie non euclidienne reliés à la théorie des cordes dans l’Univers élégant de Brian Greene. Voilà bien la conséquence d’une recherche personnelle, quand on est chercheur sans papiers !

Ironiquement, ce nouveau modèle standard s’appuie sur trois composantes dont la plus grande partie nous échapperait : la matière, ce maigre 4% d’atomes qui composerait l’Univers. Elle serait déclassée par la matière sombre qui en constituerait 21% et l’énergie sombre qui complèterait le tout de ses 75%… donc un beau 96 % qui manque à l’appel; nous vivons dans un tel Univers, pourtant !

Que conclure momentanément ? Beaucoup de phénomènes cosmologiques qu’on ne comprend pas encore, malgré nos observations les plus poussées, peuvent nous plonger dans la perplexité. Les données les plus récentes recueillies par le satellite WMAP - c’est un peu le fils du premier satellite COBE - appuieraient le nouveau modèle inflationniste de l’Univers pour soutenir le nouveau modèle standard, plus particulièrement cette nécessité de disposer de suffisamment d’énergie pour que cette inflation soit possible.

Pour les esprits plus curieux, qui veulent réviser les fondations du nouveau modèle cosmologique, un suite d’articles intéressants permet de faire le tour de ce sujet assez rapidement; une espèce de Cosmologie 101 qui reprend les éléments essentiels pour comprendre notre Univers, à la lumière de l’expertise des scientifiques du vaste projet de recherche gravitant autour des observations réalisées à l’aide de WMAP.

------------------------------------------------------------------------------------------

VIDEO :

La gravitation régit les mouvements des astres, l’orbite des planètes autour des étoiles, la rotation des galaxies. Grâce à elle, les galaxies peuvent se regrouper en amas, les amas en superamas. Sa portée gigantesque en fait le « maître de l’Univers »…

Où nous trouvons-nous dans cette immensité spatiale ? Comment l’Univers a-t-il évolué depuis le Big Bang ? Quelques éléments de réponse…

Réalisation : Jean-Christophe Monferran

Montage : Michel Castre

Crédit images : Institut d'Astrophysique de Paris (CNRS)

© CSI

---------------------------------------------------------------------------

La simulation numérique repousse les limites de la connaissance de l'Univers

Credit C. Pichon, D. Aubert.

Credit C. Pichon, D. Aubert.

Avec près de 70 milliards de particules et plus de 140 milliards de mailles, le calcul réalisé au CCRT représente le record absolu pour un système à N2 corps modélisé par ordinateur. Pour la première fois dans l’histoire du calcul scientifique, il est possible de décrire la moitié de l’univers observable tout en couvrant une galaxie comme la Voie Lactée avec plus d’une centaine de particules !

Pour simuler un tel volume avec autant de détails, les membres du Projet Horizon ont utilisé les 6144 processeurs Intel Itanium2® du calculateur BULL NovaScale 3045 récemment installé au CCRT pour faire fonctionner à plein régime le programme « RAMSES ». Celui-ci, développé au CEA en collaboration avec les astrophysiciens du Projet Horizon, met en jeu une grille adaptative3 permettant d’atteindre une finesse spatiale inégalée (l’équivalent d’une grille cubique de 262144 mailles de côté !). Grâce aux experts de BULL et du CCRT, ce programme a pu utiliser de façon optimale les ressources de l’ordinateur pendant près de deux mois, consommant plus de 18 Tera octets de mémoire vive et générant près de 50 Tera octets de données sur disque. Le même projet, réalisé sur un ordinateur individuel, aurait pris plus de mille ans !

« Avec cette nouvelle simulation, nous allons pouvoir prédire quelle est la distribution de matière dans l’Univers avec une précision et un réalisme sans précédent », poursuit Romain Teyssier. « Nous pourrons bientôt comparer le modèle avec les observations de tout le ciel bientôt disponibles grâce à la mission spatiale Planck de l’Agence spatiale européenne, dont le lancement est prévu en 2008. Nous allons aussi préparer les futures expériences de lentille gravitationnelle4, comme le projet « Dark UNiverse Explorer » dont l’objectif est de déterminer la nature de l’énergie noire ».

*Projet Horizon : il s’agit d’une collaboration entre le CEA, le CNRS et les Universités regroupant une vingtaine de chercheurs et d’enseignants, experts en simulation numérique et spécialistes de la formation des structures dans l’univers. Pour plus de détails, voir le site http://www.projet-horizon.fr.

**CCRT : ce centre de calcul haute performance est installé sur le site du CEA-DAM Ile-de-France et fait partie du complexe de calcul du CEA. Il dispose d’une puissance de calcul de plus de 50 Tera Flops pour permettre au CEA et à ses partenaires industriels (EDF, Safran, Onera, EADS/Astrium) et académiques de relever les défis aussi bien scientifiques qu’industriels de leurs projets de simulations numériques haute performance.

1. Ce rayonnement est la trace fossile de l’Univers lorsqu’il est enfin devenu transparent à la lumière: il est alors âgé de 380 000 ans. Cette lumière nous parvient 13 milliards d’années plus tard, et nous donne accès aux conditions qui régnaient alors dans le plasma cosmologique.

2. On appelle « système à N corps » un ensemble de points matériels, ou “particules” qui subissent leur attraction gravitationnelle mutuelle. Les systèmes à N corps demandent l’utilisation d’ordinateurs puissants pour pouvoir calculer les trajectoires de chaque particule.

3. Pour résoudre les équations de la mécanique des fluides à l’aide des ordinateurs, on discrétise l’espace en petits éléments de volumes ou “mailles”. Cet ensemble de mailles, que l’on appelle « grille » ou « maillage », recouvre le système que l’on souhaite décrire, dans le cas présent une large fraction de l’Univers. Pour améliorer la précision du calcul, on utilise des mailles plus petites dans les régions denses comme les galaxies : le maillage s’adapte automatiquement en fonction des conditions locales, d’où le terme « maillage adaptatif ».

4. La lumière provenant des galaxies les plus lointaines est défléchie par l’effet gravitationnel de la matière qui se trouve sur son trajet. Cet effet de “lentille”, prédit par la théorie de la relativité générale d’Einstein, permet de mesurer la quantité de matière présente entre ces galaxies et nous, et donc de tester l’ensemble de la théorie de formation des structures de l’Univers.

Communiqué de presse commun CEA/CCRT/BULL

A consulter :

- Le site internet du Dapnia/CEA pour en savoir plus sur le projet Horizon

- ----------------------------------------------------------------------

Galaxy formation with large scale parallel computing

Le Projet Horizon a pour objectif de fédérer les activités en simulation numérique autour d’un projet ciblé sur l’étude de la formation des galaxies. Son but est de comprendre les mécanismes physiques très complexes à l’origine de la structure et de la distribution des galaxies qui nous entourent, et notamment la nôtre : la « Voie Lactée ». Dans un contexte favorable aux initiatives en calcul scientifique, le Programme National de Cosmologie (PNC), le Programme National des Galaxies (PNG) et le Programme AstroParticules (PAP) ont exprimé le besoin de stimuler et de rationaliser les efforts individuels au sein de chacune des deux disciplines. Le Projet Horizon est né du rapprochement de 5 équipes de recherche dans différents instituts. Son objectif scientifique porte spécifiquement sur la formation des galaxies dans un cadre cosmologique, et vise à fédérer les activités nationales dans ce domaine. Le Projet Horizon n’a donc pas pour vocation d’épuiser tous les thèmes de recherche dans les deux domaines. Sa nature transverse et fédérative devra néanmoins permettre de développer en quelques années des compétences en calcul parallèle et distribué (GRID), en base de donnée d’observations virtuelles et en mathématiques appliqués, tout en gardant une forte composante théorique en astrophysique.

L’accroissement prodigieux des moyens de calcul dans le monde permet des percées scientifiques toujours plus spectaculaires. Les architectures actuelles, dites « architectures massivement parallèles », permettent d’atteindre des mémoires et des vitesses toujours plus grandes, et par là même de résoudre des problèmes scientifiques toujours plus ambitieux. La complexité de ces machines croît malheureusement au même rythme : les simulations deviennent de plus en plus lourdes, l’analyse en local devient de plus en plus difficile, et demande une organisation complexe et efficace des ressources. Ainsi, pour bénéficier pleinement de l’essor des moyens de calcul, il est nécessaire de mettre en commun des moyens humains, matériels et logiciels. C’est l’objectif du Projet Horizon : regrouper les forces de plusieurs instituts au sein d’un même projet, afin d’exploiter au mieux les ressources informatiques centralisées en France (CCRT, IDRIS, CINES) et de permettre aux deux communautés du PNC et du PNG d’accéder facilement à des résultats de simulations de niveau international.

De façon à permettre l’éclosion d’un tel groupe d’experts en simulations numériques, il est vital de mettre au point un projet avec des objectifs scientifiques bien définis : le Projet Horizon a pour but d’étudier la formation des galaxies dans un cadre cosmologique. Ainsi, notre projet ne cherche pas à couvrir toutes les activités du PNC, mais uniquement celles qui concernent la formation des galaxies. De même, notre projet ne cherche pas à épuiser tous les aspects scientifiques du PNG, mais uniquement ceux qui ont un rapport direct avec la cosmologie.

Objectifs du Projet Horizon

1. Étudier numériquement la Formation des Galaxies dans un Cadre Cosmologique

2. Développer des techniques de pointe en programmation parallèle et en mathématiques appliquées pour simuler la formation des galaxies dans un cadre cosmologique, et prédire leurs signatures observationnelles en fonction de divers ingrédients physiques.

3. Regrouper plusieurs experts du domaine pour échanger leur savoir-faire, mettre en commun des logiciels et rationaliser l’accès aux centres de calculs nationaux.

4. Donner à la communauté française du PNC, PNG et PAP (observateurs et théoriciens) un accès convivial à des résultats de simulations de niveau international.

http://irfu.cea.fr/Phocea/Vie_des_labos/Ast/ast_technique.php?id_ast=905

----------------------------------------------------------------------------

Le programme "Formation des galaxies avec Mare Nostrum", une collaboration multidisciplinaire de scientifiques d'Allemagne, Espagne, Etats-Unis, Israël et France, parmi lesquels des astrophysiciens du Service d'Astrophysique du CEA/DAPNIA , vient de débuter une des plus imposantes simulations numériques jamais entreprises. A l'aide d'un super-calculateur constitué d'un réseau de 2048 processeurs en parallèle, les calculs simulent l'évolution d'un cube d'Univers de 150 millions d'années de côté contenant environ 10 milliards d'éléments. Après l'équivalent d'environ un million d'heures de calcul répartis sur plus de 4 mois, cette simulation va retracer plusieurs milliards d'années d'existence de l'Univers et permettre de comprendre le processus de formation des galaxies.

L'ère des Univers virtuels

Le développement des super-calculateurs utilisant des réseaux de processeurs permet actuellement d'atteindre des capacités de calcul dépassant les 20 mille milliards d'opérations par seconde (ou 20 TeraFlops [1]). Dans le cadre d'un projet principalement européen, une de ces puissantes machines est récemment entrée en service au Centre de Supercalculs de Barcelone (Espagne). Elle est constituée de 2048 processeurs PowerPC 970 MP travaillant en parallèle pour résoudre en un temps minimum les équations mathématiques décrivant l'évolution de l'Univers. Malgré la puissance de la machine, quatre mois seront nécessaires pour retracer les quinze milliards d'années écoulées depuis le début de l'expansion cosmique, alors qu'un ordinateur personnel aurait nécessité 114 ans de calculs !

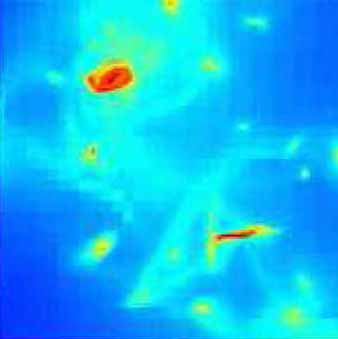

Simulation de la répartition de la matière dans un "cube" d'Univers. Les couleurs représentent la densité de matière (codée en intensité croissante du noir au blanc). Les concentrations denses où se forment les galaxies sont reliées par de longs filaments (Droits: R.Teyssier/CEA).

Cette simulation, la plus ambitieuse jamais entreprise a débuté en septembre 2006. Elle permet de suivre l'évolution de dix milliards d'éléments, une finesse de détails jamais atteinte auparavant. Des dispositifs spéciaux ont été mis en place pour sauvegarder régulièrement les étapes du calcul en cas de pannes matérielles pour éviter le redémarrage depuis le début. Chaque étape représente l'état d'un cube d'Univers virtuel à une époque donné de son évolution. Les calculs prennent en compte l'évolution sous l'action de la gravité de la matière, dont la majorité est constituée de matière noire [2], à partir de très faibles inhomogénéités présentes au tout début de l'expansion. La succession des images en trois dimensions permettra de comprendre dans quelles régions et sous quelles formes apparaissent les première galaxies. A l'issue du calcul, la quantité totale de données produite dépassera les 40 TeraBytes [3].

Contact : Romain TEYSSIER

Le projet "Formation des galaxies avec MareNostrum " est une collaboration multidisciplinaire entre des astrophysiciens de France, Allemagne, Espagne, Israël and Etats-Unis et des experts en informatique de l'IDRIS (Institut du Développement et des Ressources en Informatique Scientifique) et du BSC (Barcelona Supercomputing Center). Elle utilise les ressources du MareNostrum (IBM), le plus puissant super-calculateur en Europe (le cinquième dans le monde) installé au BSC en 2004 et dont la capacité a été porté en novembre 2006 à 10.240 processeurs avec une puissance de calcul de 94.21 Teraflops[2].

voir :| - la simulation numérique astrophysique au SAp (7 janvier 2007) | |

| - COAST - Simulations astrophysiques au CEA. (en anglais) | |

| - le projet HORIZON - Formation des galaxies) (en anglais) | |

| - "l'Univers selon MareNostrum" - Institut d'Astrophysique de Paris (IAP) (janvier 2007) |

voir aussi

| - Simulation des premiers âges (15 novembre 2005) | |

| - Zoom sur la matière sombre (10 Juillet 2003) | |

| - Les fluctuations de l'Univers primordial (1 Octobre 2002) |

43 Teraflops : nouvelle étape pour le calcul français

La simulation numérique est devenu un outil essentiel pour de nombreuses disciplines comme l'aéronautique, l'énergie, les sciences de la vie ou l'astrophysique. Pour répondre à cette demande en France, le Centre de Calcul Recherche et Technologie (CCRT) vient de signer un contrat avec la société BULL pour l'installation d'un nouveau calculateur d'une puissance de calcul record de 43 Teraflops[1]. Constitué d'un réseau de serveurs Bull NovaScale équipés de processeurs Itanium, il sera intégré au complexe de calcul du CEA pour créer une des plus puissantes infrastructures de calculs scientifiques au monde. Ce super-calculateur va être déployé progressivement à partir du début 2007 pour atteindre sa puissance maximale à la fin 2008.

[1] FLOPS : pour Floating-point Operations Per Second (opérations à virgule flottante par seconde) caractérise la puissance de calcul des ordinateur. 1 TéraFLOPS = 1000 milliards de FLOPS.

[2] Matière noire : Matière inconnue totalement différente de celle que nous connaissons, qui n’émet aucune lumière et qui n’interagit avec la matière des atomes que par la gravitation. Dans la théorie du Big Bang, son existence est indispensable pour expliquer la formation des galaxies. Activement recherchée dans des laboratoires souterrains, elle pourrait être constituée de particules hypothétiques appelées WIMPS (pour Weakly Interactive Massive particules) prédites par certaines théorie de la matière.

[3] TeraBytes pour 1,000,000,000,000 bytes = 10004 ou 1012 bytes ou 1 TB. 1 Byte caractérise l'unité de mémoire des ordinateurs et correspond à un octet (série de 8 zeros ou un) servant à coder un caractère typographique. 10 TeraBytes équivaut au contenu en texte de l'ensemble de la Bibliothèque Nationale

07-01-2007 (1175)

Sommaire SAP

Sommaire SAP  Services : Le service d'Astrophysique

Services : Le service d'Astrophysique  Expériences :

Expériences : http://irfu.cea.fr/Sap/Phocea/Vie_des_labos/Ast/ast_actu.php?id_ast=1175

----------------------------------------------------------------------------

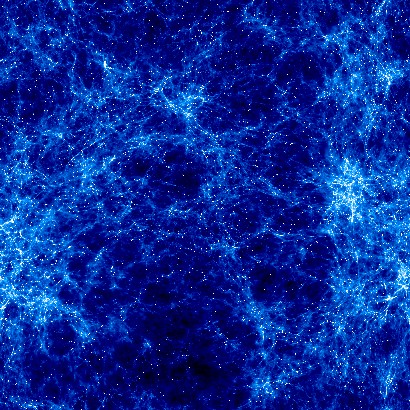

Simulation numérique de la formation des structures dans un univers en expansion, réalisée sur 256 processeurs au CCRT à Bruyères-le-Châtel

-------------------------------------------------------------------------

Des simulations à très haute résolution réalisées au Service d'Astrophysique (SAp) du CEA-DAPNIA, viennent de fournir une idée précise du rôle joué par la matière ordinaire (dite baryonique) dans l'évolution de l'Univers. Dans le modèle cosmologique actuelle, la majeure partie de la matière dans l'Univers est en effet une "matière noire" de nature encore inconnue, toute la matière ordinaire (gaz chaud, gaz froid, étoiles ou gaz diffus intergalactique) ne fournissant qu'une très faible composante (moins de 10%). Les simulations montrent pourtant que par le jeu de la formation des étoiles et du gaz expulsé des galaxies, cette matière ordinaire influe notablement sur la formation des galaxies depuis le Big Bang et façonne ainsi l'Univers. Ces simulations, dont certaines incluent plus d'un demi milliard de mailles, utilisent des techniques numériques sophistiquées (Raffinement Adaptatif de Maillage) qui permettent de simuler à la fois l'Univers dans son ensemble et les régions beaucoup plus petites où se forment les galaxies. Elles sont parmi les plus puissantes jamais réalisées pour étudier la formation des galaxies. Ces travaux sont publiés dans la revue "Astronomy & Astrophysics".

Les galaxies des premiers âges

Les plus puissants télescopes du monde (VLT, Keck, HST...), grâce à leur observations profondes, remontent de plus en plus loin dans l'histoire de l'Univers. Ils y dévoilent toute une variété de galaxies à l'histoire tumultueuse, marquées par d'incessantes collisions et des phases d'intense formation d'étoiles...

D'où viennent ces galaxies? Comment se sont-elles formées? On considère actuellement que les premières galaxies se sont formées à partir de grumeaux primordiaux dans la soupe du Big Bang, de petites fluctuations de densité dans le gaz chaud primordial en expansion. De telles fluctuations ont en effet été observées par le satellite WMAP dans le fond diffus cosmologique, la "première lumière" émise par l'Univers quelques 300 000 ans après le Big Bang. Il s'avère que l'Univers, à cette époque, était presque homogène. Presque seulement et c'est là le point important car de petites inhomogénéités de très faible amplitude (un millionième de la densité moyenne de l'Univers à cette époque) étaient présentes. Ces petites fluctuations de densité ont pu ensuite être amplifiées par la gravité et conduire à la formation de petit halos de matière de la taille et de la masse de certains amas d'étoiles actuels (environ un million de masses solaires) quand l'Univers n'avait que quelques centaines de millions d'années. Ces halos ont pu ensuite voir leur masse croître progressivement de fusion en fusion pour donner les vastes halos de matière dont la masse atteint environ mille milliard de fois la masse du Soleil et qui semblent envelopper les galaxies que nous connaissons à l'heure actuelle. Les petites structures précédant les plus grosses, ce modèle porte le nom de "modèle hiérarchique"

Mais dans le modèle cosmologique actuel, la majeure partie de la matière dans l'Univers est une matière "noire" de nature inconnue. Quel rôle joue alors la matière ordinaire ? Comment arrive-t-on aux galaxies pleines d'étoiles?

En réalité, comme la matière noire domine en masse, c'est elle qui, par sa gravité, joue un rôle essentiel dans la condensation du gaz chaud primordial en halos de matière. Ainsi, le gaz de matière ordinaire agit plus en spectateur au début de l'histoire de l'Univers. Il chute au centre des halos de matière noire pour former des halos de gaz chaud. Mais, les chocs entre les atomes d'hydrogène et entre les atomes d'hélium qui composent le gaz, rayonnent progressivement de l'énergie qui jusque là soutenait le gaz. Inévitablement, celui-ci s'effondre alors jusqu'à créer des disques de gaz froid. Ce gaz, petit à petit se transforme ensuite en étoiles et laisse alors place à un magnifique disque d'étoiles: une galaxie est née!

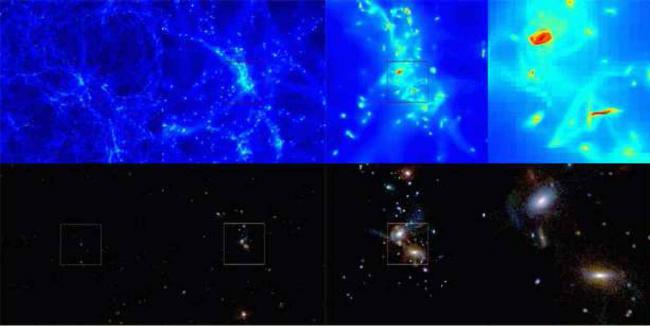

Simulation numérique de formation des grandes structures. De gauche à droite, chaque image correspond à un agrandissement d'un facteur 4 par rapport à l'image précédente. Le cadre définit la région agrandie. En haut, la couleur correspond à la densité du gaz projetée. Dans la boite initiale de 45 millions d'années-lumière de coté, on découvre les filaments aux grandes échelles. Chaque point est en fait une galaxie. En zoomant sur 2 d'entre elles, on voit 2 disques de gaz froid. En bas, ce sont les mêmes régions, mais pour les étoiles. La densité d'étoiles est codée en intensité lumineuse tandis que l'âge des étoiles est codé par les couleurs. Les étoiles jeunes sont plus bleues et les étoiles vieilles sont plus rouges. Les galaxies obtenues montrent un disque d'étoiles jeunes et un halo d'étoiles plus âgées similaires à ce qui est observé aujourd'hui.(Crédit CEA/SAp)

Ce sont toutes ces phases successives qui ont pu être reproduites par les simulations numériques puissantes menées au SAp. Les scientifiques ont utilisé pour cela le code de calcul sur ordinateur RAMSES développé par Romain Teyssier, basé sur une méthode numérique sophistiquée appelé "Raffinement Adaptatif de Maillage". Ils reproduisent ainsi parfaitement l'apparition des objets de tailles très différentes (voir l'image).

Le vent des galaxies

Mais voilà, comme dans tout scénario, il y a toujours un imprévu! En effet, la quantité finale d'étoiles atteint 40% (par rapport à la masse totale de matière ordinaire) alors que les observations semblent indiquer des valeurs de l'ordre de 10% seulement! Ils semblent donc manquer un ingrédient essentiel qui diminue la formation d'étoiles. Quel est-il? L'équipe du Sap a comparé la quantité de gaz froid, de gaz chaud et d'étoiles obtenue dans les simulations aux valeurs réellement observées. Pour éviter la surproduction d'étoiles, il semble nécessaire d'invoquer une perte de matière des galaxies sous forme de "vents galactiques". Ces vents éjectent le gaz du disque froid jusque dans le halos de gaz chaud et réduisent ainsi la quantité de gaz disponible pour la formation d'étoiles. Plus précisément, si la quantité de gaz éjecté par les vents galactiques est équivalent à celui qui forme les étoiles alors, la composition baryonique de l'Univers devient en bon accord avec les observations.

Un vent galactique dans M82 observé par le téléscope Subaru. La couleur rouge correspond au gaz chaud ionisé qui s'échappe du disque (crédits Subaru).

Mais d'où viennent ces vents, comment se forment-ils? Pour répondre à cette question, il faut revenir aux observations des galaxies proches. Certaines galaxies, comme la galaxie Messier 82, sont dans des phases de flambées de formation d'étoiles. Elles présentent souvent des gerbes de gaz chaud et ionisé en provenance du disque: ce sont des "vents galactiques". L'origine de ces vents pourrait être une explosion quasi-simultanée (en quelques centaines de millions d'années) d'un grand nombre d'étoiles. Ces explosions produiraient des bulles de gaz chaud qui monteraient jusqu'à percer la surface du disque et former les jets que l'on observe. Ensuite, en fonction de son énergie, le gaz peut soit être éjecté à tout jamais, soit retomber sur le disque pour former de magnifiques "fontaines galactiques"! Pour les galaxies les plus massives, ils se pourraient aussi que les trous noirs supermassifs supposés au centre de nombreuses galaxies aient eux aussi leur mot à dire. Ils pourraient même produire alors des vents encore plus énergétiques dans leur phase d'activité.

Contacts :

Yann RASERA

Romain Teyssier

voir aussi : "Zoom sur la matière sombre" (10 Juillet 2003)

"The History of the Baryon Budget: Cosmic Logistics in a Hierarchical Universe"

Yann Rasera, Romain Teyssier , à paraitre dans la revue "Astronomy & Astrophysics"

pour une version électronique (fichier PDF, 1,34 Mo)

15-11-2005 (1189)

Sommaire SAP

Sommaire SAP  Services : Le service d'Astrophysique

Services : Le service d'Astrophysique L’étude des grandes structures de l’Univers a connu un essor fulgurant depuis une vingtaine d’années, après la découverte des fluctuations de température du fond diffus cosmologique par le satellite COBE en 1992 (récompensée par le prix Nobel de physique 2006). C’est en effet à partir de cette mesure que notre connaissance des « conditions initiales » de notre univers est devenue suffisamment précise pour envisager l’étude de son évolution dynamique au cours de ses 13 à 14 milliards d’années d’existence. Au cours de cette évolution, les petites fluctuations primordiales de densité vont croître sous l’effet de l’instabilité gravitationnelle, et former les galaxies et les amas de galaxies que l’on observe aujourd’hui.

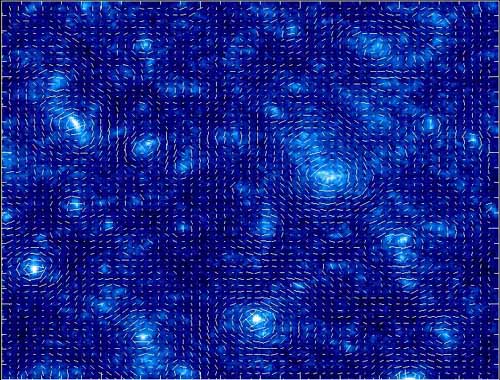

---------------------------------------------------------------------------En présence d'une forte concentration de matière, visible ou sombre, la lumière ne va plus en ligne droite. Elle est déviée par l'action de la gravitation de la matière comme à travers une lentille. Cet effet de "lentille gravitationnelle", prévu par la Théorie de la Relativité Générale, est aujourd'hui observé par les grands télescopes. Il déforme l'image des galaxies comme un véritable kaléidoscope cosmique et permet ainsi de cartographier la distribution de la masse dans l'Univers. Cette nouvelle technique est actuellement mise en oeuvre par plusieurs équipes internationales d'astronomes qui mesurent le "cisaillement cosmique", de très faibles distorsions produites sur les images des galaxies lointaines par les grandes structures (galaxies et amas de galaxies) sur la ligne de visée.

Une importante revue de synthèse sur ce sujet, écrite par Alexandre Refregier, chercheur du Service d'Astrophysique du CEA-DAPNIA Saclay, va paraître cet automne dans la série "Annual Review of Astronomy and Astrophysics". Elle comprend un historique de ce domaine en évolution rapide, un état des lieux des mesures les plus récentes et une présentation des perspectives offertes par les futures instruments.

Inscrivez-vous au blog

Soyez prévenu par email des prochaines mises à jour

Rejoignez les 527 autres membres